كيف يؤثر الذكاء الاصطناعي على خصوصية الموظفين في بيئة العمل الحديثة؟

أصبح استخدام أدوات الذكاء الاصطناعي، مثل “شات جي بي تي” (ChatGPT) من “أوبن إيه آي” (OpenAI) و”كوبايلوت” (Copilot) من “مايكروسوفت” (Microsoft)، جزءاً أساسياً من الحياة اليومية في قطاع الأعمال. ومع تسارع تطور هذه الأدوات، تزداد المخاوف بشأن الخصوصية والأمان، لا سيما في بيئات العمل.

في المقابل، يشعر قادة الأعمال بضغط متزايد لاعتماد تقنيات الذكاء الاصطناعي، مما يجعل بناء الثقة وفهم تأثير هذه الأدوات على سير العمل أمراً ضرورياً للاستفادة الكاملة من إمكاناتها.

خصوصية الموظفين في مواجهة الذكاء الاصطناعي

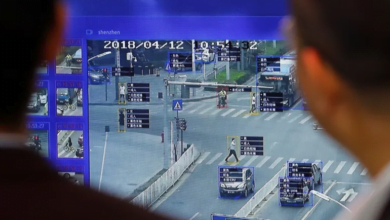

أثارت أداة “ريكول” (Recall) من “مايكروسوفت” -التي تلتقط لقطات شاشة للحاسوب كل بضع ثوانٍ- جدلاً واسعاً، حيث وصفتها بعض الجهات المدافعة عن الخصوصية بأنها “كابوس الخصوصية”. وقد دفعت هذه التقنية هيئة تنظيم المعلومات في المملكة المتحدة إلى طلب مزيد من المعلومات حول أمان هذه الأداة قبل إطلاقها كجزء من “كوبايلوت بلس” (+Copilot). كما أثيرت مخاوف مماثلة حول “شات جي بي تي”، الذي قد يتسبب في كشف بيانات حساسة عند استخدامه على نظام “ماك أو إس” (macOS).

قيود استخدام أدوات الذكاء الاصطناعي في بيئات العمل

حظرت عدة جهات، مثل مجلس النواب الأميركي، استخدام أدوات مثل “كوبايلوت” بسبب مخاوف من تسريب البيانات إلى خدمات سحابية غير معتمدة. وبالمثل، حذرت شركة “غارتنر” من مخاطر استخدام “كوبايلوت” في تطبيقات “مايكروسوفت أوفيس 365″، مشيرة إلى احتمالية تسريب البيانات الحساسة داخلياً وخارجياً. وقد قامت “غوغل” مؤخراً بتعديل ميزة “إيه آي أوفرفيوز” (AI Overviews) بعد أن تم الكشف عن إجابات مريبة وغير دقيقة.

أهمية بناء الثقة

يرى الخبراء أن التحدي الأكبر يكمن في كيفية حماية البيانات الحساسة في ظل استخدام الذكاء الاصطناعي. يؤكد مايكل بوش، الرئيس التنفيذي لشركة “غريت بليس تو وورك”، أن الثقة بين الموظفين والمنظمات ضرورية لفهم كيفية تأثير الذكاء الاصطناعي على سير العمل وتعزيز تبني إمكاناته.

اعتبارات للحفاظ على خصوصية الموظفين

لتحقيق التوازن بين فوائد الذكاء الاصطناعي وحماية خصوصية الموظفين، يجب اتباع مجموعة من التدابير، منها:

- تدابير أمان البيانات: التأكد من أن أنظمة الذكاء الاصطناعي تحتوي على تدابير قوية تشمل التشفير وضوابط الوصول.

- الشفافية: أن يكون هناك وضوح في كيفية استخدام الذكاء الاصطناعي والبيانات المجمعة.

- الحد من جمع البيانات: الاكتفاء بجمع البيانات الضرورية فقط لتحقيق أهداف الذكاء الاصطناعي.

- إخفاء هوية البيانات: إزالة المعلومات الشخصية القابلة للتحديد من مجموعات البيانات المستخدمة.

- التدريب والإرشادات: توجيه الموظفين حول الاستخدام الأمثل لمنصات الذكاء الاصطناعي.

- تقييمات تأثير الخصوصية: إجراء تقييمات منتظمة لتقييم المخاطر المرتبطة باستخدام الذكاء الاصطناعي.

بناءً على هذه المبادئ، يمكن لأصحاب العمل تعزيز الثقة وتبني الذكاء الاصطناعي بطرق تضمن حماية الخصوصية وتحقيق الأهداف المؤسسية.